编辑:元子、张佳

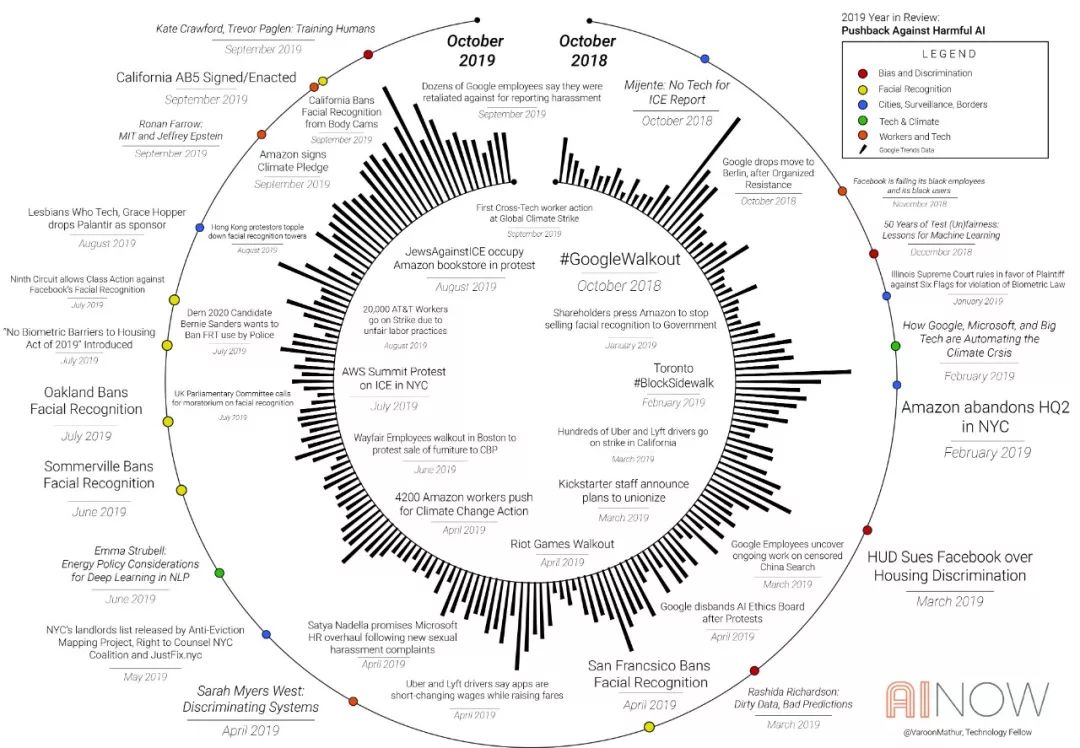

近日,纽约大学AI Now Institute 第四届年度AI Now研讨会在纽约大学举办,AI Now联合创始人凯特·克劳福德(Kate Crawford)和梅雷迪斯·惠特克(Meredith Whittaker)进行了简短的演讲,总结了一年来的关键时刻,并着重讨论了五个主题:

-

面部表情和情感识别;

-

从“AI偏见”向正义的转变;

-

城市、监视、边界;

-

劳工、工人组织和AI,

-

人工智能对气候的影响。

接下来和大家分享演讲的摘录。

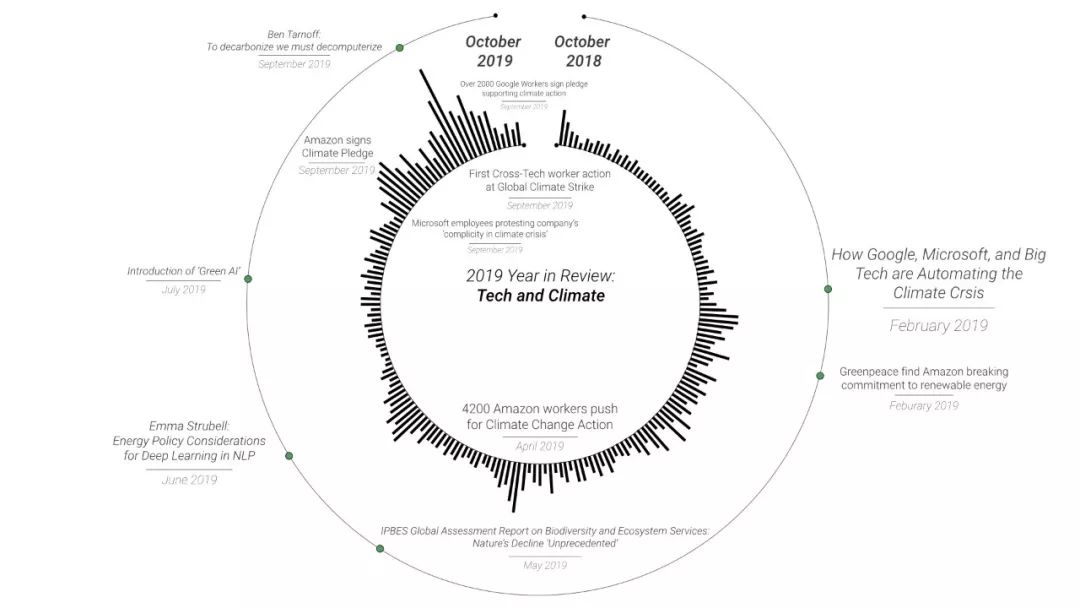

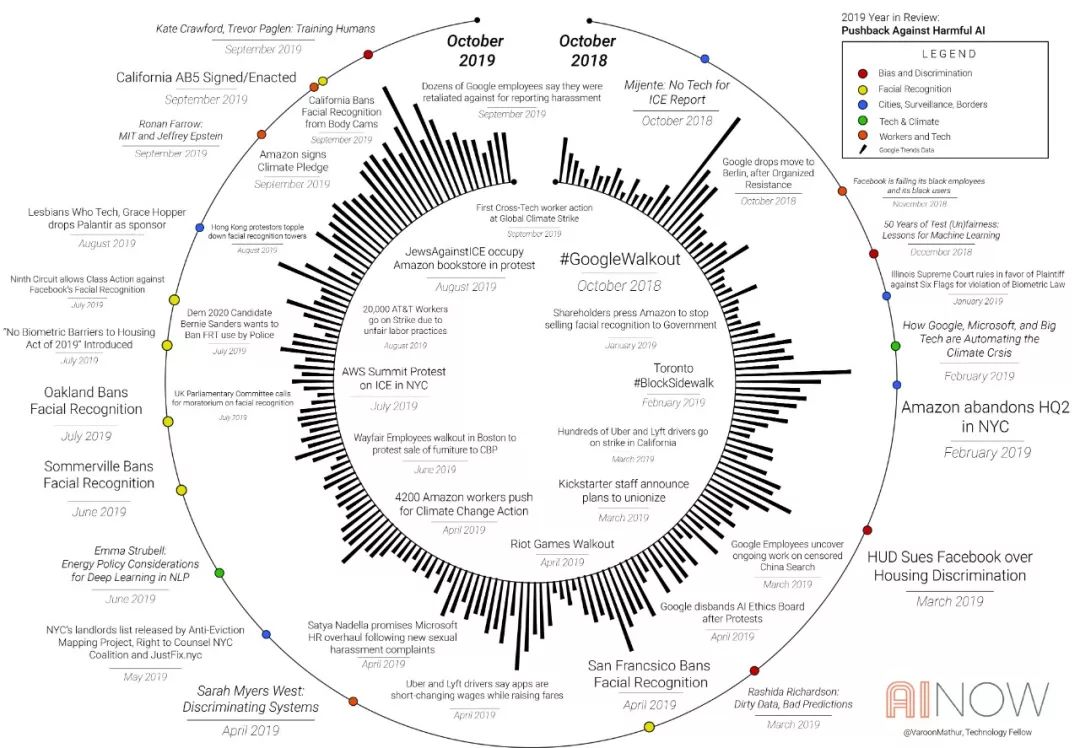

一张图回顾今年AI大事

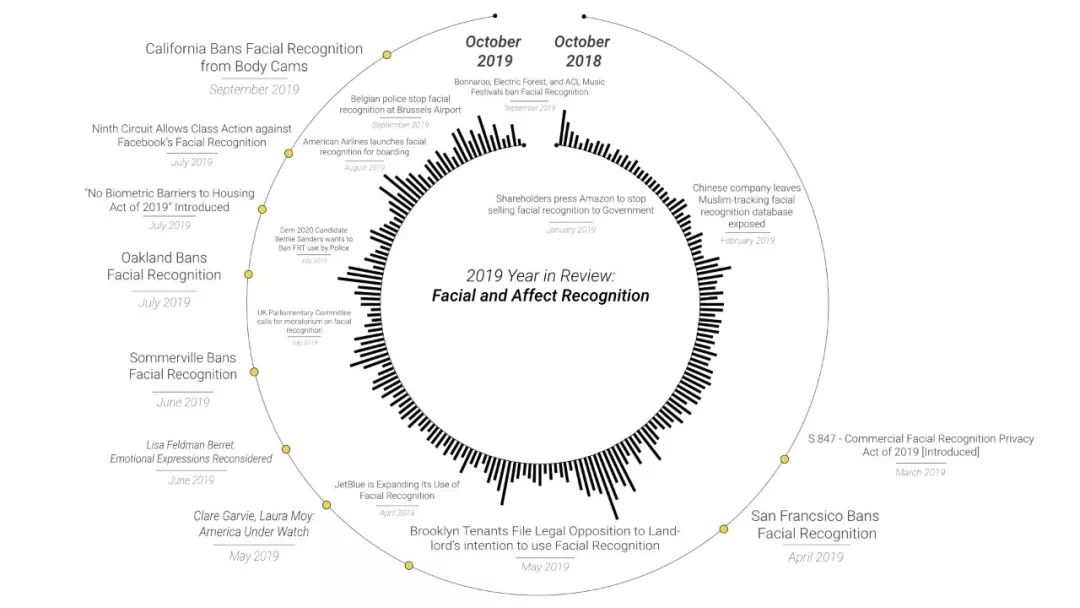

公众对面部和表情识别更加警惕

在2019年,公司和政府加大了在公共住房、招聘和城市街道中推广面部识别的力度。现在,一些美国航空公司甚至使用它代替登机牌,声称这样做更方便。

情感识别(面部识别的一个子集)也得到了更广泛的使用,它声称可以通过解释面部的微表情来“读取”我们的内在情绪。正如心理学家Lisa Feldman Barret在一份广泛的调查报告中所表明的那样,这种类型的人工智能没有可靠的科学基础。但是,它已经被用于教室和工作面试中,而且常常是在人们不知情的情况下。

例如,Georgetown隐私和技术中心获得的文件显示,FBI和ICE(美国移民和海关执法局)一直在悄悄访问驾照数据库,在未经个人同意或未经州或联邦立法者授权的情况下,对数百万张照片进行面部识别搜索。

但是今年,在严格限制使用面部识别的学者和组织者(如美国公民自由协会的Kade Crockford,罗切斯特理工学院的Evan Selinger和东北大学的Woodrow Hertzog)的呼吁之后,选民和立法者开始改变。第九巡回上诉法院(The Ninth Circuit Court of Appeals)最近裁定,Facebook可能因未经许可而对用户的照片进行面部识别而被起诉,称这是对隐私的侵犯。

由于媒体正义(Media Justice)等组织的领导,旧金山于今年5月签署了第一个面部识别的禁令。紧接着又有两个城市禁止面部识别。现在有一个总统候选人承诺全国范围内的禁令,音乐家们要求在音乐节上停止面部识别,并且有一项名为“ No Biometric Barriers to Housing Act”的联邦法案,将焦点聚焦在公共房屋中的面部识别。

面部识别在欧洲同样受阻,英国议会委员会要求在建立法律框架之前停止对面部识别的试验,布鲁塞尔警方最近对这些工具的测试被发现是非法的。

当然,这些改变需要大量工作。我们要清楚的是,这不是需要完善技术方面或消除偏见的问题。考虑到被监视、跟踪和逮捕的人在种族和收入方面的差异,即使是非常准确的面部识别也会产生不同的危害。正如凯特·克劳福德最近在《自然》杂志上所写的那样 :消除这些系统的偏见不是重点,它们“失败时是危险的,成功时是有害的”。

从“AI 偏见”到正义

今年,我们还看到了一些重要的转变,从狭隘的专注于纯技术的AI“去偏见”转向更加关注正义。

许多令人不安的事件在一定程度上推动了这一点。

例如,密歇根州的前州长里克·斯奈德(Rick Snyder)是一名技术主管,他决定安装一个全州范围的自动化决策系统,称为MiDAS。它的目的是自动标记涉嫌福利欺诈的工人。为了削减成本,该州安装了MiDAS并解雇了整个欺诈检测部门。但是事实证明,MiDAS系统有93%的时间是错误的。它错误地指控了40,000多名居民,从而引发了许多破产甚至自杀事件。但是,MiDAS只是一系列更大的紧缩政策的一部分,这些政策的重点是寻找穷人当替罪羊。

另一个例子来自AI Now的政策主管Rashida Richardson领导的研究,她研究了警察日常工作和预测性警务软件之间的联系。她和她的团队发现,在美国许多警察部门中,预测性警务系统可能会使用来自种族主义和腐败的警务记录。

显然,在这种情况下纠正偏差与删除数据集中的变量无关。它需要更改警察制作数据的做法。人权数据分析小组的研究人员Kristian Lum在她关于算法如何放大警务中的歧视性的开创性工作中也表明了这一点。

凯特·克劳福德和AI Now艺术家研究员Trevor Paglen最近还在他们的Training Humans展览中提到了分类政治,这是首个大型艺术展,旨在研究用于创建机器学习系统的训练数据。该项目考察了AI训练集的历史和逻辑,从1963年Woody Bledsoe进行的第一次实验到最著名和使用最广泛的基准集,例如Wilded Labeled Faces和ImageNet。

ImageNet Roulette是与展览一起提供的视频安装和应用程序。

今年9月,在数百万人上传了他们的照片,以查看他们将如何被ImageNet分类后,这一消息在网上流传开来。这是一个具有重大意义的问题,ImageNet是规范的对象识别数据集,它在塑造AI产业方面做得比任何其他行业都多。

虽然ImageNet的一些分类很奇怪,甚至很有趣,但数据集中也充斥着非常有问题的分类,其中许多是种族主义者和厌女主义者(misogynist)。Imagenet Roulette提供了一个界面,使人们可以查看AI系统如何对他们进行分类。克劳福德和帕格伦Paglen发表了一篇调查性文章,揭示了他们如何揭开多个基准训练集的面纱,以揭示其政治结构。

这也是为什么艺术和研究结合在一起有时会比单独的影响更大的原因,这使我们考虑由谁来定义我们所处的类别,以及由此产生的后果。

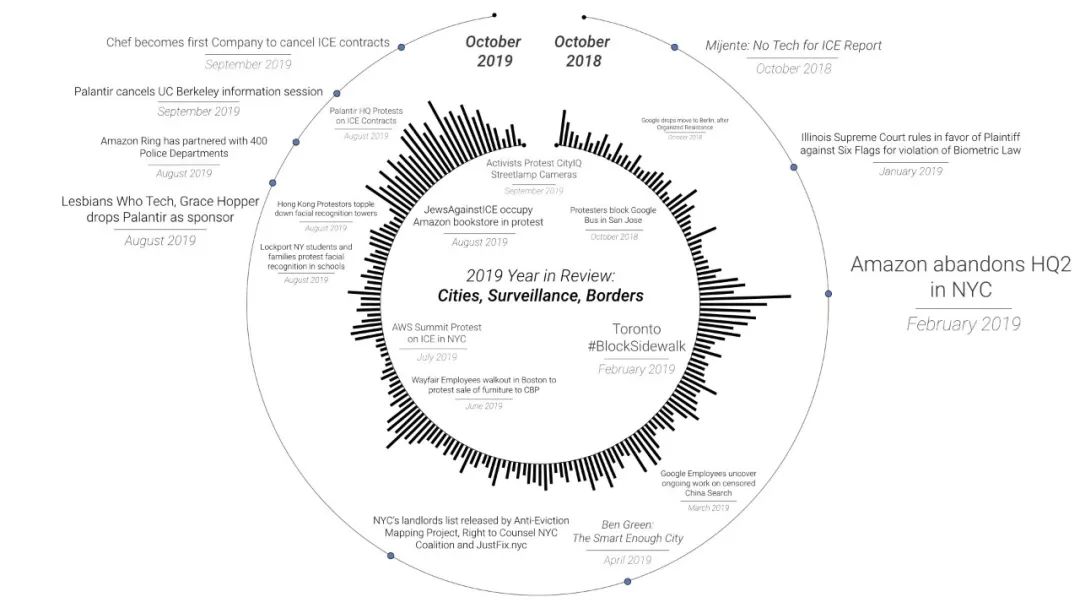

城市,监视,边界

能源、分类和控制问题,是今年在美国范围内大规模部署公司监视系统的前提。以亚马逊的Ring为例,它是一款监控摄像头和门铃系统,旨在使人们能够24小时监控家和附近地区。

亚马逊正在与400多个警察部门合作推广Ring,希望警察说服当地民众购买该系统。这样的行为,有点像将警察变成挨家挨户上门推销的安防产品销售员。

作为交易的一部分,亚马逊将持续获取视频内容,同时为警察提供一个视频访问入口,可以随时调用监控视频。

该公司已经在该领域申请了人脸识别专利,表明他们希望能够将视频中的人脸与“可疑人员数据库”进行比对,从而有效地在全国范围内建立私有化的家庭监控系统。

但是Ring并非解决问题的最佳方案。正如Burku Baykurt,Molly Sauter和AI Now研究员Ben Green这样的学者所表明的那样,“智慧城市”的技术乌托邦式言论,掩盖了更深层次的不公正和不平等问题。

居民社区开始考虑这个问题。8月,圣地亚哥居民抗议安装“智能”灯杆。

今年6月,纽约州洛克波特市的学生和家长抗议学校使用的面部识别系统,该系统使该地区能够随时追踪和绘制任何学生或老师的信息,现已暂停工作。

2月份纽约的一个大型联合组织,迫使亚马逊放弃了其在皇后区的第二个总部。该组织负责人强调,纽约不光给亚马逊提供了庞大的激励计划,还有亚马逊的劳动实践,面部识别技术的部署以及与ICE的合同。

当然,这些工具最被滥用的情况之一是在美国南部边境。ICE,海关和边境巡逻队正在部署AI系统。

目前,有52000名移民被关在监狱、拘留所以及其他限制人身自由的场地。40000名无家可归的人在边境的墨西哥一侧等待庇护。在过去的一年中,有7名儿童在ICE拘留中死亡,许多儿童面临食物和医疗不足的问题。

根据宣传组织Mijente的报告,我们知道像亚马逊和Palantir这样的公司正在为ICE提供驱逐难民出境的理由。

为了反对驱逐行动以及对抗科技巨头和ICE,已经有来自数十所大学的2000多名学生签署了不与Palantir合作的保证书;而与ICE签约的科技公司总部几乎每周都有抗议活动。

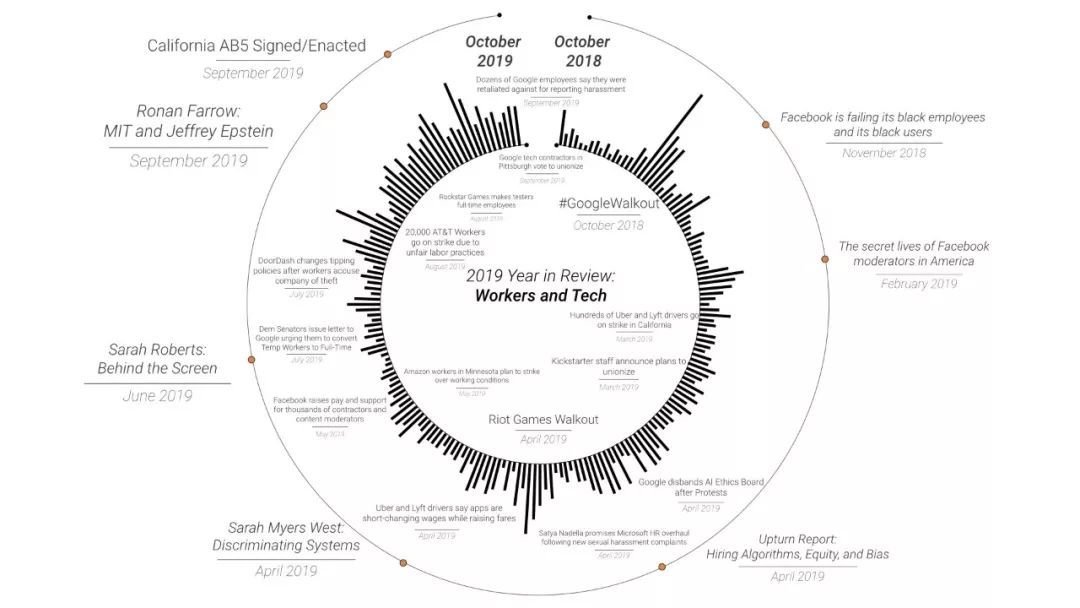

劳工,工会和人工智能

当然,当我们检查AI领域日益增长的多样性问题时,种族,阶级和性别等方面的结构性歧视问题将得到充分展示。

4月,AI Now发布了由博士后Sarah Myers West领导的Discriminate Systems。这项研究展示了AI内部的歧视性文化、与AI系统中嵌入的偏见及歪曲事实之间的反馈回路。

调查结果令人震惊。正如AI行业将自己标榜为财富和权力的纽带一样,它也变得更加同质。整个领域显然存在一个普遍的问题。

但是,也有人不断呼吁求变。爆料人希恩·斯文森(Signe Swenson)和记者罗南·法罗(Ronan Farrow)帮助揭示了麻省理工学院的筹款文化,这种文化将地位和金钱置于妇女和女孩的安全之上。

最早要求问责的人之一是肯尼亚研究生Arwa Mboya。她讨要公道做法,像极了当初处于社会底层、无权无势的有色人种妇女争取权利而发声的状态。但是,麻省理工学院当然并非个案。

从Google罢工到Riot game,再到与CEO面对面的Microsoft工人,我们已经看到了多家科技公司的一系列罢工和抗议,所有这些都要求消除工作中的种族和性别不平等。

AI Now联合创始人梅雷迪思·惠特克(Meredith Whittaker)于今年早些时候离开了Google。她对行业的发展方向越来越感到震惊。事情变得越来越糟,而不是更好。因此,她和她的同事们开始围绕工作场所中AI的有害使用和滥用进行梳理。

AI Now的研究和许多其他学者的研究也为这项梳理工作提供了信息,这些研究为政治行动和组织提供了宝贵的指导。科技工作者运动不断发展也取得了一些重大胜利。

合同工是这个故事的关键部分,他们是最早使用技术进行组织的人。

在许多科技公司中,他们占劳动力的一半以上,他们没有得到全面的就业保障,他们的收入通常勉强维持生计。Lilly Irani,莎拉·罗伯茨,杰西卡·布鲁德和玛丽·格雷等学者的著作帮助吸引了对这些影子劳动力的关注。

用于工人管理的AI平台也是一个日益严重的问题。从Uber到亚马逊的仓库,这些庞大的自动化平台可指导员工行为,设定绩效目标并确定员工工资,从而使员工完全受制于AI。例如,在今年早些时候,Uber大幅削减了工人的工资,没有任何解释或警告,而是通过对其平台的更新悄悄地实施了这一变更。

幸运的是,我们也看到了这些工人的一些重大胜利。CA的Rideshare工人在AB-5法中取得了巨大胜利,该法要求基于应用程序的公司向驾驶员提供全面的就业保护。

AI的气候影响

所有这些问题的背景都是气候。

人工智能非常耗能,消耗大量自然资源。来自Amherst的研究员Emma Strubell在今年早些时候发表了一篇论文,揭示了训练AI系统的巨大碳消耗。她的团队表明,仅创建一种用于自然语言处理的AI模型,就可以排放多达600000磅的二氧化碳,相当于在纽约和北京之间的125次往返飞行的耗能。

大型AI的碳消耗足迹通常隐藏在诸如“云”之类的抽象产品后面。实际上,据估计,世界计算基础设施的碳排放量与航空业一样多,占全球排放量的很大比例。

不断增长的反抗

越来越多的反对浪潮涌现。

你可以看到一股越来越大的反对浪潮正在出现。从拒绝承认面部识别是不可避免的,到我们家园和城市中的追踪技术,大量的重要工作正在进行中。

很明显,人工智能引发的问题主要是社会,文化和政治问题,而非技术问题。这些问题,从刑事司法到工人权利,再到种族和两性平等,都有悠久的历史。

我们仍然有一个机会来决定可以接受哪种类型的AI、以及让它们负什么责!

原文链接:

https://medium.com/@AINowInstitute/ai-in-2019-a-year-in-review-c1eba5107127

声明:本文来自新智元,版权归作者所有。文章内容仅代表作者独立观点,不代表士冗科技立场,转载目的在于传递更多信息。如有侵权,请联系 service@expshell.com。

联系我们

联系我们 在线留言

在线留言 京公网安备11011202100645号

京公网安备11011202100645号