前言

当前,全球人工智能正处于技术创新、重塑行业、重新定义我们与技术互动方式的快速更迭阶段,人工智能的治理风向呈现出从软法向硬法转变的明显趋势。截至2024年,全球已有69个国家和地区制定了多部人工智能相关政策,涵盖隐私保护、数据监管、伦理规范及AI治理等广泛主题,反映了各国对AI技术发展的重视以及对其潜在风险的管理需求。但就人工智能监管出台专门立法的国家,仍然是少数。本文主要介绍欧盟、美国和英国的人工智能监管框架。

2023年9月5日,委员会指定Apple为其操作系统 iOS、浏览器 Safari 和 App Store的看门人。同一天,欧盟委员会启动了一项市场调查,以评估苹果的iPadOS尽管没有达到DMA中规定的数量门槛,但是否构成企业用户接触最终用户的重要门户,因此应被指定为看门人。

一、欧盟

目前,欧盟针对人工智能的监管立法主要有《人工智能法》和《人工智能责任指令》。其中,《人工智能法》由欧洲理事会于2024年5月21日批准通过,明确了欧盟的人工智能监管基调——基于风险的方法。这是全球首部最为全面、最具影响力的人工智能法规,预计于今年正式实施。

1. 《人工智能法》

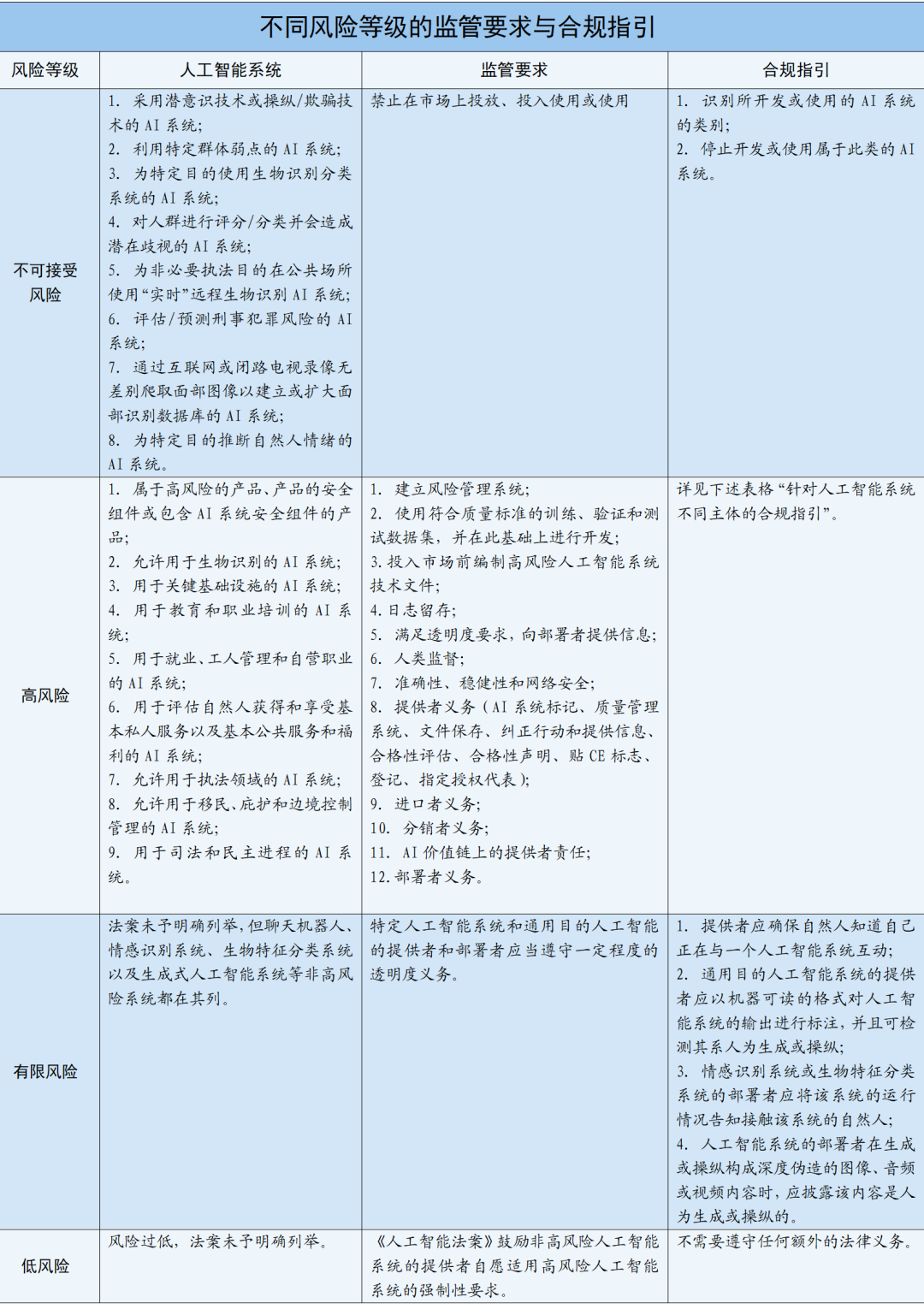

《人工智能法》将人工智能系统分为不可接受的风险、高风险、有限风险和低风险四级,并明确了不可接受风险和高风险的人工智能系统类别,以及对应的监管要求。下表在梳理法案规范的基础上,总结监管要求,并提出有针对性的合规指引。

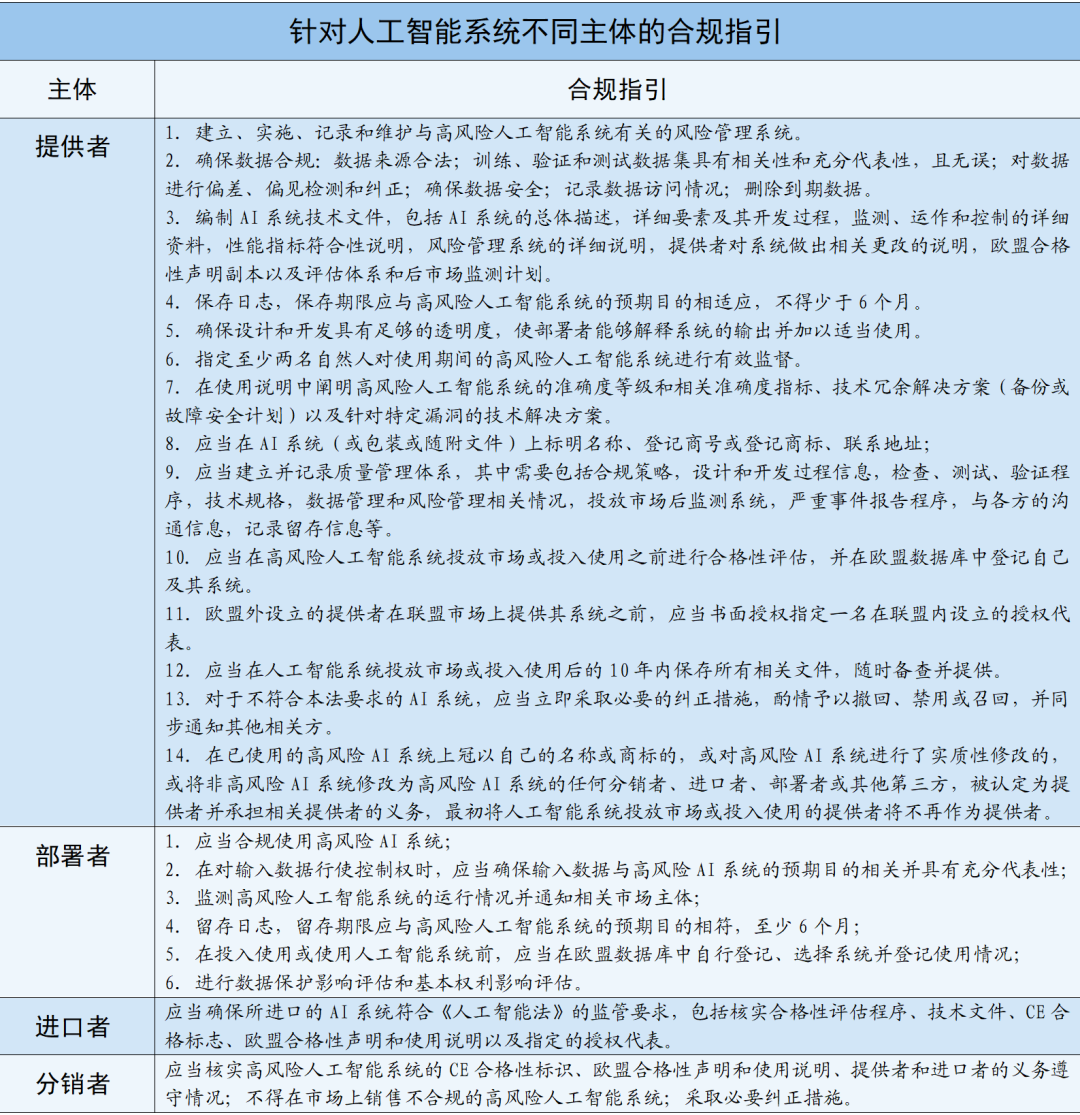

该立法的核心关切在于高风险人工智能系统,法案也通过大量篇幅为高风险人工智能系统的相关主体设定了合规义务。主要包括如下内容:

2. 《人工智能责任指令》

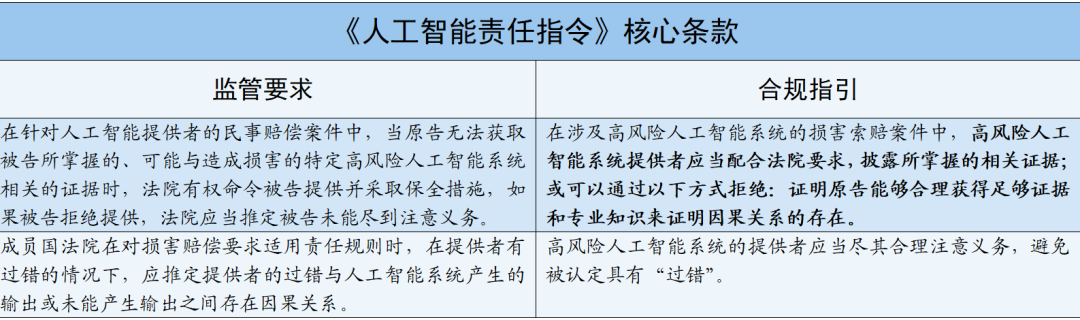

除《人工智能法》,欧盟委员会也在同步制定《人工智能责任指令》(Artificial Intelligence Liability Directive)。该指令草案于2022年9月28日被提出,旨在为人工智能系统造成的非合同过失的特定类型损害提供统一规则,解决举证责任难的问题,确保受到人工智能技术伤害的人能够获得经济补偿。

该责任指令共有中核心条款的监管要求及合规指引总结如下:

欧盟在人工智能监管方面的行动表明,欧盟致力于成为科技监管方面的全球引领者,从潜在风险角度出发进行谨慎立法,并积极回应人工智能侵权损害中的责任承担现实需求与面临的困境,反映出欧盟重视基本权利保障的法律传统与监管思路。

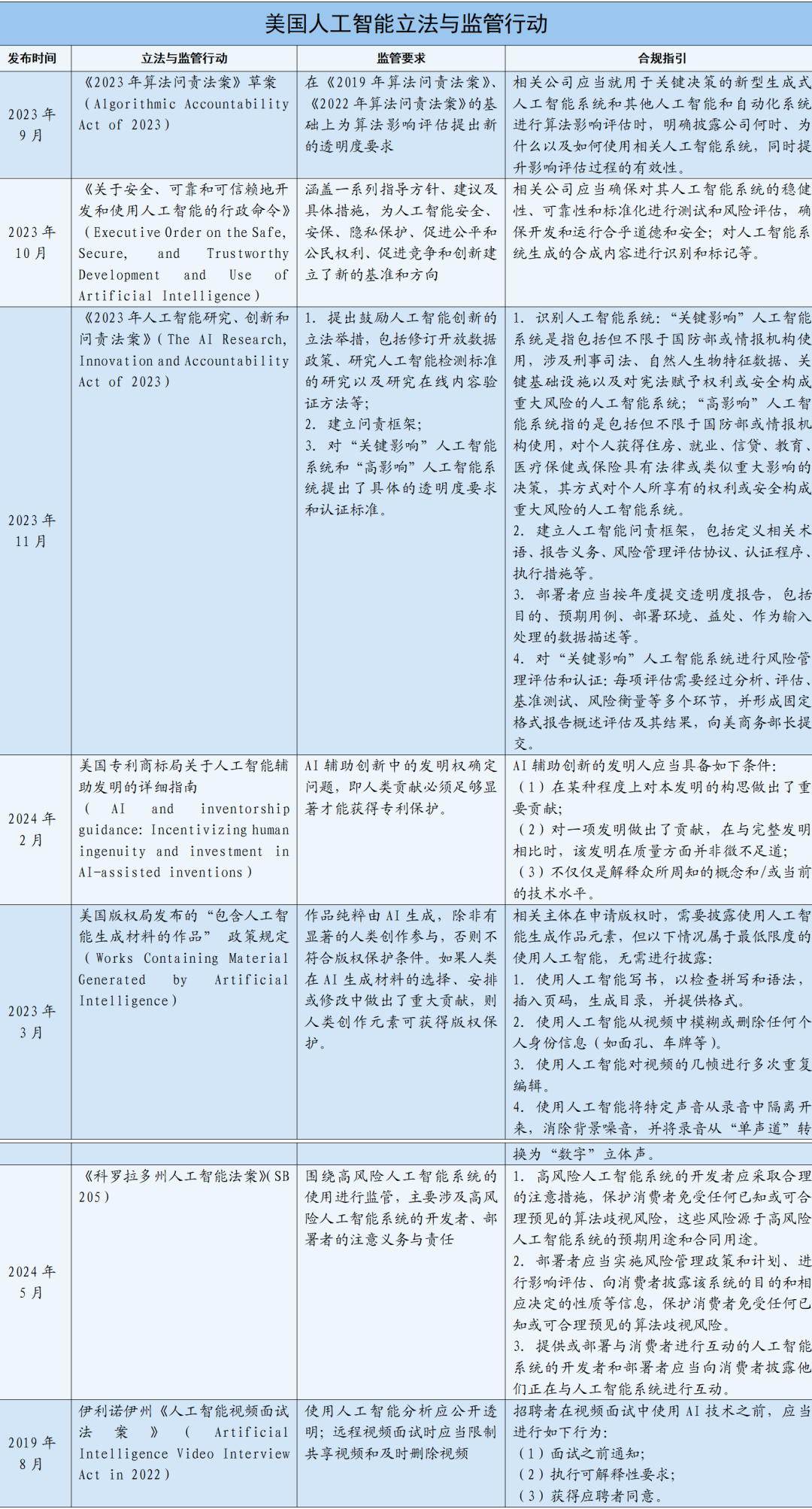

二、美国

与欧盟不同,美国在人工智能监管方面选择了针对特定行业的方法(sector-specific approach)。换言之,美国并没有制定联邦层面的全国性人工智能法律,而是和美国在其他关键领域所采取的监管模式一致,即通过分散的联邦立法、州立法、行业立法进行监管,具体情况详见下表。

值得明确的是,关于人工智能在招聘和晋升中的使用问题,美国加利福尼亚州、新泽西州、纽约州、佛蒙特州和华盛顿特区也提出了相关立法予以规范。上表仅就美国州层面的立法进行了选择性举例说明。

三、英国

英国目前采取“支持创新”(pro-innovation approach)的监管方法,这一方法明确提出于《人工智能监管的促进创新方法》(A pro-innovation approach to AI regulation)。英国声称不会很快通过任何关于人工智能监管的法律,因为英国政府认为对企业严格、繁重的立法要求可能会阻碍人工智能创新,并降低政府对未来的技术进步做出快速和相称的反应。

目前,英国的监管思路是基于伦理框架指导人工智能的负责任发展和使用,具体包括安全、可靠和稳健、适当的透明度和可解释性、公平、问责制和治理以及可诉性和补救五项伦理原则。由监管机构负责实施这些原则,找出其中任何的可能性障碍,并就该框架是否达到预期效果予以评估。如果该框架被证实有效,英国将不会通过立法引入法定义务。

四、总结

综上所述,欧盟、美国和英国在人工智能立法与监管方面的立场与所采取的进路都有所区分。欧盟侧重基本权利保护,采取风险导向的监管路径;美国侧重行业发展,采取行业需求导向的监管路径;英国侧重鼓励创新,采取市场创新导向的监管路径。然而,无论采取何种监管模式,全球人工智能发展都始终面临着技术风险与权利保障、科技创新与政府监管之间的平衡难题,有待进一步立法探索与尝试。

本文作者

王梦菲,赛博研究院 研究员

声明:本文来自赛博研究院,版权归作者所有。文章内容仅代表作者独立观点,不代表士冗科技立场,转载目的在于传递更多信息。如有侵权,请联系 service@expshell.com。

联系我们

联系我们 在线留言

在线留言 京公网安备11011202100645号

京公网安备11011202100645号